Istio服务网格实战:若依微服务系统灰度发布与流量管控全解析

一、实际应用场景背景

企业数字化转型中,微服务架构虽带来灵活性,但服务间通信复杂度激增。当企业使用若依框架构建业务系统时,如何在不中断业务的前提下实现新功能上线和版本迭代成为关键挑战。通过Istio服务网格与若依微服务集成,可实现精准的流量控制和灰度发布策略,确保业务平稳过渡。

二、若依项目架构简介

若依(RuoYi)是一套基于Spring Boot和Spring Cloud的开源微服务系统,包含多个核心服务模块:

- ruoyi-gateway:网关服务,负责请求路由和权限控制

- ruoyi-auth:认证授权服务,处理用户登录和Token验证

- ruoyi-system:系统管理服务,包含用户、角色、菜单等基础功能

- ruoyi-modules:业务模块服务集合,如订单、商品等业务功能

这些服务通过Kubernetes和Kustomize进行部署管理,在argocd-gitops 仓库中维护相关配置。

三、Istio接入准备工作

1. 环境要求

- Kubernetes集群 1.23.17

- 已部署Istio 1.15.7(参考使用Istio服务网格实现AB测试)

- 已部署若依项目服务

- 熟悉Kustomize配置管理

2. 确认若依服务部署状态

# 检查若依相关服务

kubectl get pods -n <ruoyi-namespace>

kubectl get services -n <ruoyi-namespace>

确保所有若依服务正常运行后再进行Istio接入。

四、为若依项目启用Istio Sidecar注入

1. 为命名空间启用自动注入

# 为若依项目所在的命名空间启用Istio sidecar自动注入

kubectl label namespace <ruoyi-namespace> istio-injection=enabled

# 验证标签设置

kubectl get namespace -L istio-injection

2. 重启若依服务以触发Sidecar注入

# 重启Deployment以触发Sidecar注入

kubectl rollout restart deployment/<ruoyi-deployment-name> -n <ruoyi-namespace>

3. 验证Sidecar注入结果

# 检查Pod状态,每个Pod应该包含两个容器:应用容器和istio-proxy容器

kubectl get pods -n <ruoyi-namespace>

# 查看Pod详细信息,确认istio-proxy容器已注入

kubectl describe pod <ruoyi-pod-name> -n <ruoyi-namespace>

五、为特定微服务配置Istio(可选)

如果您只想为特定的微服务(如ruoyi-system)启用Istio功能,而不是为整个命名空间启用,可以使用选择性注入的方式。

1. 禁用命名空间级别自动注入

首先确保命名空间没有启用自动注入:

# 移除命名空间的自动注入标签

kubectl label namespace <ruoyi-namespace> istio-injection-

2. 为特定Deployment启用注入

在ruoyi-system的Deployment配置中添加注入注解:

apiVersion: apps/v1

kind: Deployment

metadata:

name: ruoyi-system

namespace: <ruoyi-namespace>

spec:

replicas: 1

selector:

matchLabels:

app: ruoyi-system

template:

metadata:

labels:

app: ruoyi-system

annotations:

sidecar.istio.io/inject: "true"

spec:

containers:

- name: ruoyi-system

image: ruoyi/ruoyi-system:latest

ports:

- containerPort: 8080

3. 重启服务以应用更改

# 删除Pod以触发重建,应用新的注入配置

kubectl delete pod -l app=ruoyi-system -n <ruoyi-namespace>

4. 验证注入结果

# 检查ruoyi-system Pod是否注入了istio-proxy

kubectl get pods -n <ruoyi-namespace> -l app=ruoyi-system

# 查看Pod详细信息

kubectl describe pod <ruoyi-system-pod-name> -n <ruoyi-namespace>

六、实操步骤

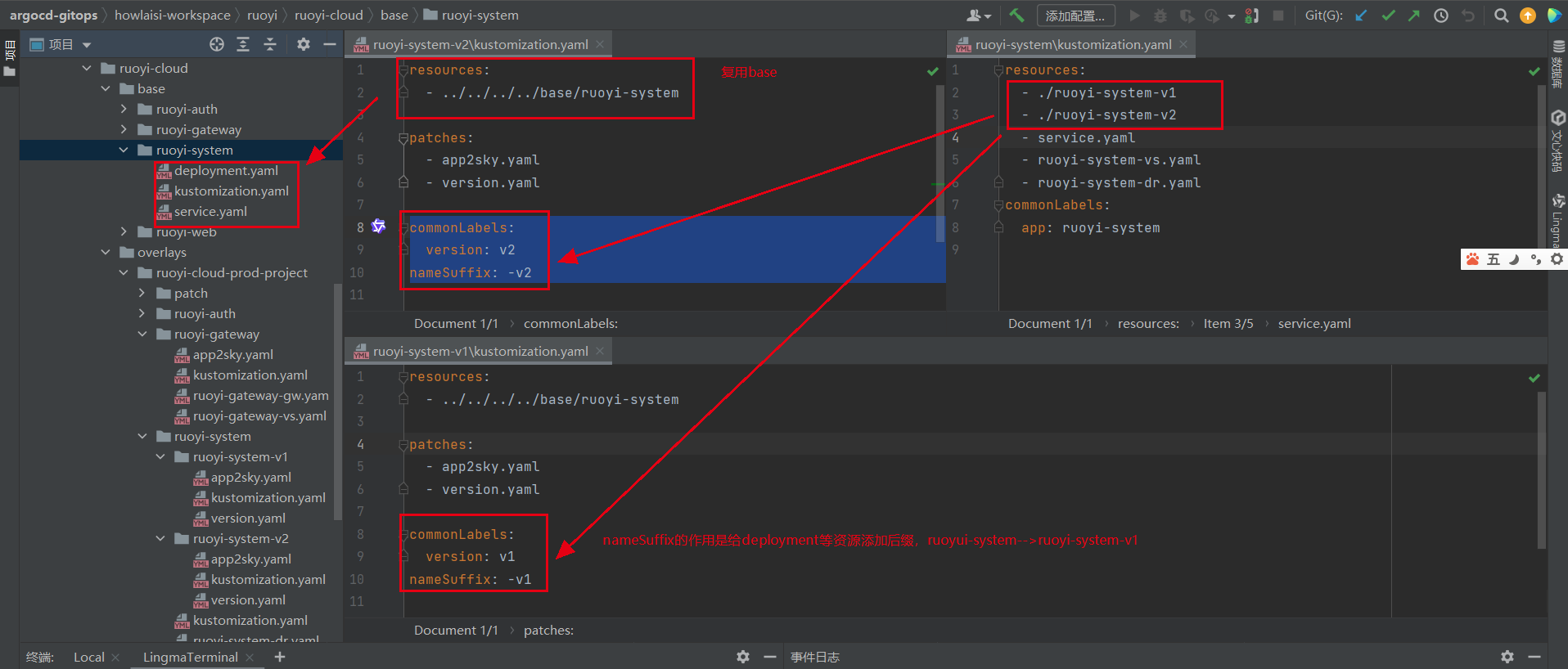

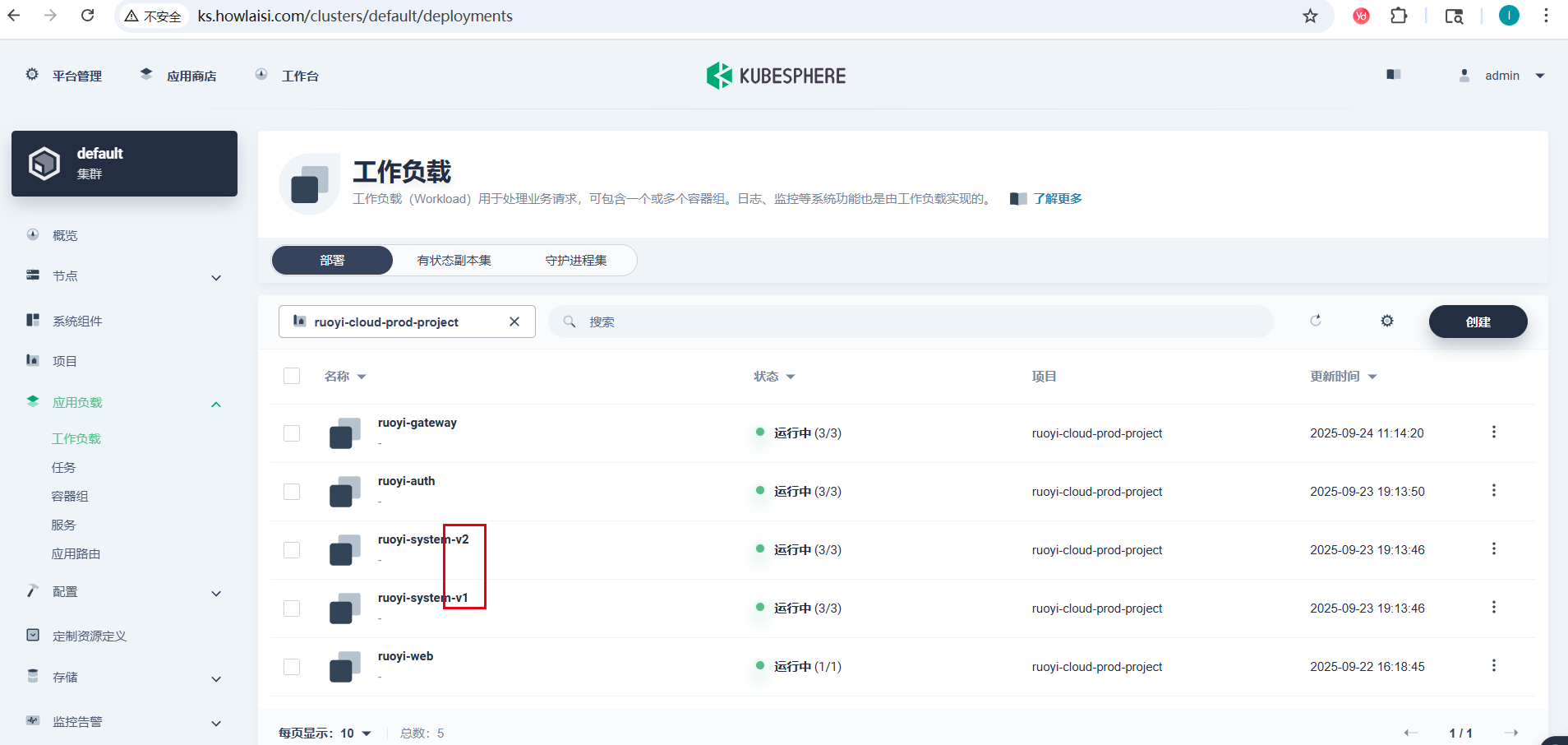

1. Kustomize配置复用策略

在ruoyi-system部署中,通过Kustomize的commonLabels和nameSuffix实现配置复用:

# ruoyi-system-v1/kustomization.yaml

resources:

- ../../../base/ruoyi-system

nameSuffix: -v1

commonLabels:

version: v1

# ruoyi-system-v2/kustomization.yaml

resources:

- ../../../base/ruoyi-system

nameSuffix: -v2

commonLabels:

version: v2

通过Kustomize的commonLabels和nameSuffix,可以复用同一个Kustomize配置文件,为不同版本的服务创建Deployment/Service等资源。

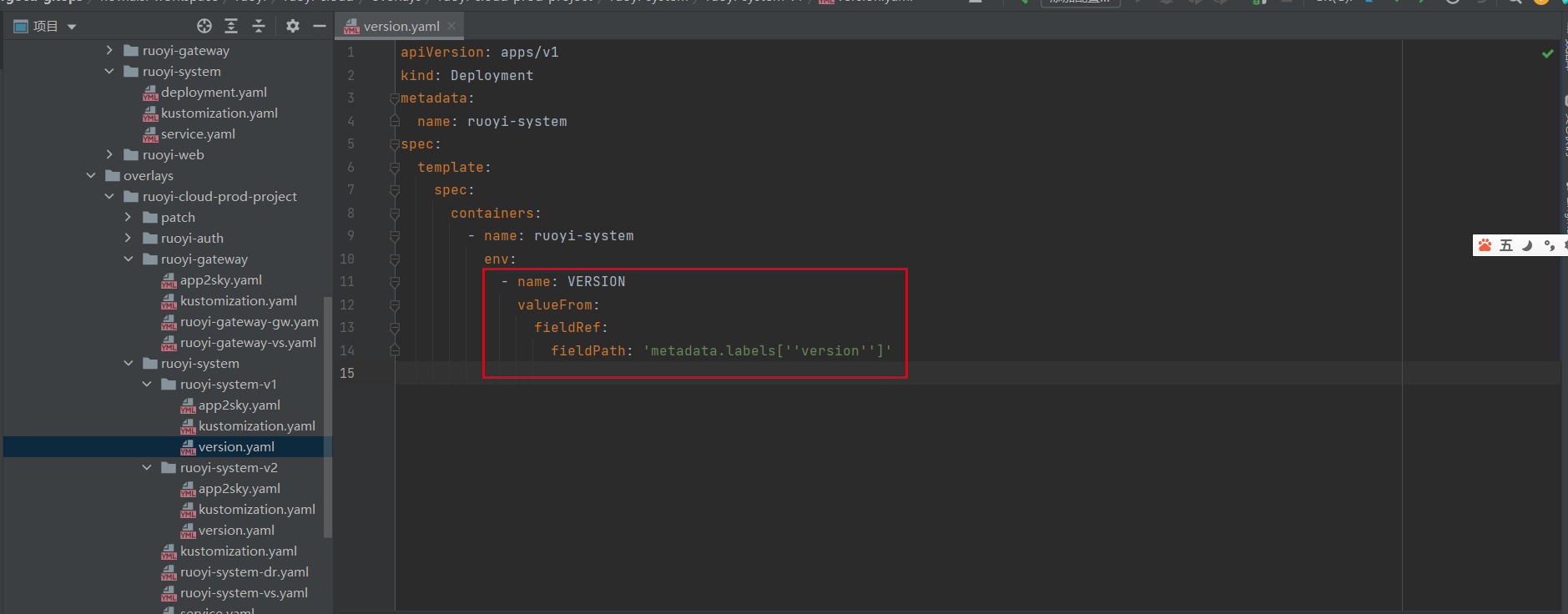

2. Downward API动态注入

通过Downward API将Pod标签中的版本信息注入到容器环境变量中:

apiVersion: apps/v1

kind: Deployment

metadata:

name: ruoyi-system

spec:

template:

spec:

containers:

- name: ruoyi-system

env:

- name: VERSION

valueFrom:

fieldRef:

fieldPath: metadata.labels['version']

这种方式利用Kubernetes的反射机制,将commonLabels中定义的version标签值动态注入到Pod环境变量,相比硬编码方式更加灵活且易于维护。

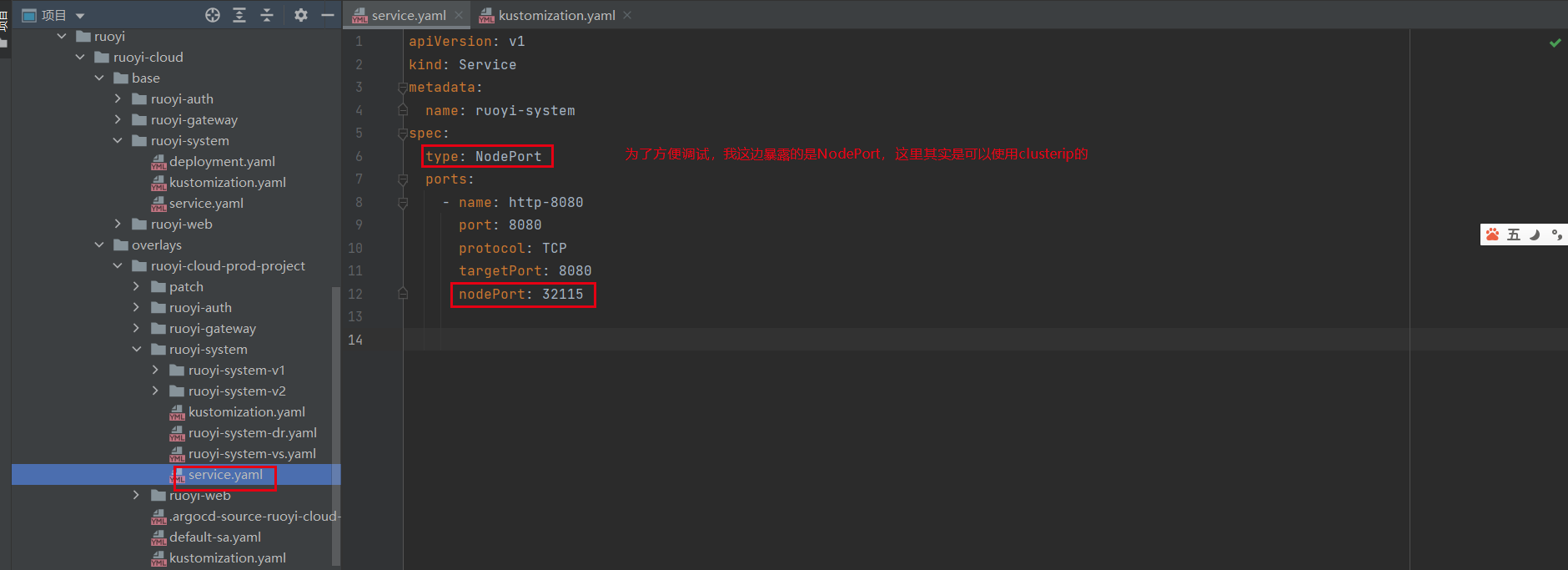

3. 创建统一的服务(Service)

为了让多个版本的服务可以通过同一个服务名访问,需要创建一个统一的Service:

apiVersion: v1

kind: Service

metadata:

name: ruoyi-system

namespace: <ruoyi-namespace>

spec:

selector:

app: ruoyi-system

ports:

- port: 8080

targetPort: 8080

protocol: TCP

name: http

4. 验证服务注册

# 查看所有ruoyi-system实例

kubectl get pods -n <ruoyi-namespace> -l app=ruoyi-system

# 检查Pod环境变量

kubectl exec -it <ruoyi-system-pod-name> -n <ruoyi-namespace> -- env | grep VERSION

# 检查Nacos注册情况(如果可以通过kubectl port-forward访问)

kubectl port-forward svc/nacos-server -n <nacos-namespace> 8848:8848

# 然后在浏览器中访问 http://localhost:8848 查看服务注册情况

七、服务注册与Nacos集成

在若依系统的Java配置文件中配置Nacos注册信息:

# spring配置

spring:

cloud:

nacos:

discovery:

ip: ruoyi-system

metadata:

version: ${VERSION:v1}

POD_IP: ${POD_IP}

将ip配置为ruoyi-system而非Pod IP,确保服务间调用通过Kubernetes Service,从而使流量经过Istio Sidecar代理。

metadata中的version和POD_IP参数,用于区分不同版本和服务实例,支持金丝雀发布和故障排查。

如果使用默认的Pod IP,流量将绕过Service直接访问Pod,导致Istio流量治理功能失效。

八、流量治理核心配置

1. DestinationRule配置

通过ruoyi-system-dr.yaml定义通信策略和版本子集:

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: ruoyi-system-dr

spec:

host: ruoyi-system

subsets:

- name: v1

labels:

version: v1

- name: v2

labels:

version: v2

2. VirtualService路由配置

通过ruoyi-system-vs.yaml实现流量控制:

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: ruoyi-system

spec:

hosts:

- ruoyi-system

http:

- route:

- destination:

host: ruoyi-system

subset: v1

weight: 90

- destination:

host: ruoyi-system

subset: v2

weight: 10

3. 为什么必须使用Service FQDN

Istio流量管理功能依赖Envoy代理实现。当使用NodePort直接访问服务时,流量会绕过Sidecar代理,导致配置的流量规则无法生效。

只有通过Service的FQDN访问,如ruoyi-system.namespace.svc.cluster.local,流量才会经过Envoy代理,从而启用完整的Istio功能。

这是因为Istio通过iptables拦截Pod内的网络流量并重定向到Envoy代理,只有通过Kubernetes Service访问时,流量才会经过这个拦截点。

九、网关配置实现外部流量接入

在外部访问若依系统时,需要通过Istio Gateway将流量路由到内部服务(可选)。可以使用ruoyi-gateway的nodeport,但是ruoyi-gateway就不能实现灰度发布。ruoyi-gateway转发的请求(fqdn)会被Envoy代理,从而实现流量治理。

1. Gateway配置

通过ruoyi-gateway-gw.yaml定义入口网关:

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: ruoyi-gateway-gw

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "*"

2. Gateway VirtualService配置

通过ruoyi-gateway-vs.yaml配置路由规则:

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: ruoyi-gateway-vs

spec:

hosts:

- "*"

gateways:

- ruoyi-gateway-gw

http:

- match:

- uri:

prefix: /

route:

- destination:

host: ruoyi-gateway

port:

number: 8080

weight: 100

十、配置Istio实现流量管理

1. 创建DestinationRule

为ruoyi-system服务创建DestinationRule以定义通信策略和版本子集:

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: ruoyi-system-dr

namespace: <ruoyi-namespace>

spec:

host: ruoyi-system

trafficPolicy:

loadBalancer:

simple: LEAST_CONN

subsets:

- name: v1

labels:

version: v1

- name: v2

labels:

version: v2

2. 配置服务间路由规则

配置VirtualService来控制ruoyi-gateway到ruoyi-system的流量:

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: ruoyi-system-vs

namespace: <ruoyi-namespace>

spec:

hosts:

- ruoyi-system

http:

- route:

- destination:

host: ruoyi-system

subset: v1

weight: 90

- destination:

host: ruoyi-system

subset: v2

weight: 10

3. 基于请求内容的路由(可选)

如果需要基于特定条件路由到不同版本,可以配置更复杂的路由规则:

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: ruoyi-system-vs

namespace: <ruoyi-namespace>

spec:

hosts:

- ruoyi-system

http:

# 基于HTTP头部的路由

- match:

- headers:

X-Version:

exact: "v2"

route:

- destination:

host: ruoyi-system

subset: v2

# 默认路由

- route:

- destination:

host: ruoyi-system

subset: v1

十一、配置验证与测试

1. 验证Sidecar注入

# 检查ruoyi-system Pod是否正确注入istio-proxy

kubectl get pods -n <ruoyi-namespace> -l app=ruoyi-system

# 查看Pod详细信息

kubectl describe pod <ruoyi-system-pod-name> -n <ruoyi-namespace>

2. 测试服务间通信

# 进入ruoyi-gateway容器测试到ruoyi-system的连接

kubectl exec -it <ruoyi-gateway-pod> -n <ruoyi-namespace> -- curl http://ruoyi-system:8080/actuator/health

3. 验证版本环境变量

# 检查Pod环境变量

kubectl exec -it <ruoyi-system-pod-name> -n <ruoyi-namespace> -- env | grep VERSION

4. 观察流量分布

通过Kiali仪表板观察服务间流量分布和服务健康状态:

# 启动Kiali端口转发

kubectl port-forward svc/kiali 20001:20001 -n istio-system

十二、故障排除

1. 检查Istio配置

# 检查Istio配置是否正确应用

istioctl analyze -n <ruoyi-namespace>

# 查看VirtualService配置

kubectl get virtualservices -n <ruoyi-namespace>

# 查看DestinationRule配置

kubectl get destinationrules -n <ruoyi-namespace>

2. 查看日志和指标

# 查看ruoyi-system应用日志

kubectl logs <ruoyi-system-pod-name> -c ruoyi-system -n <ruoyi-namespace>

# 查看istio-proxy日志

kubectl logs <ruoyi-system-pod-name> -c istio-proxy -n <ruoyi-namespace>

# 查看Istio组件日志

kubectl logs -n istio-system -l app=istiod

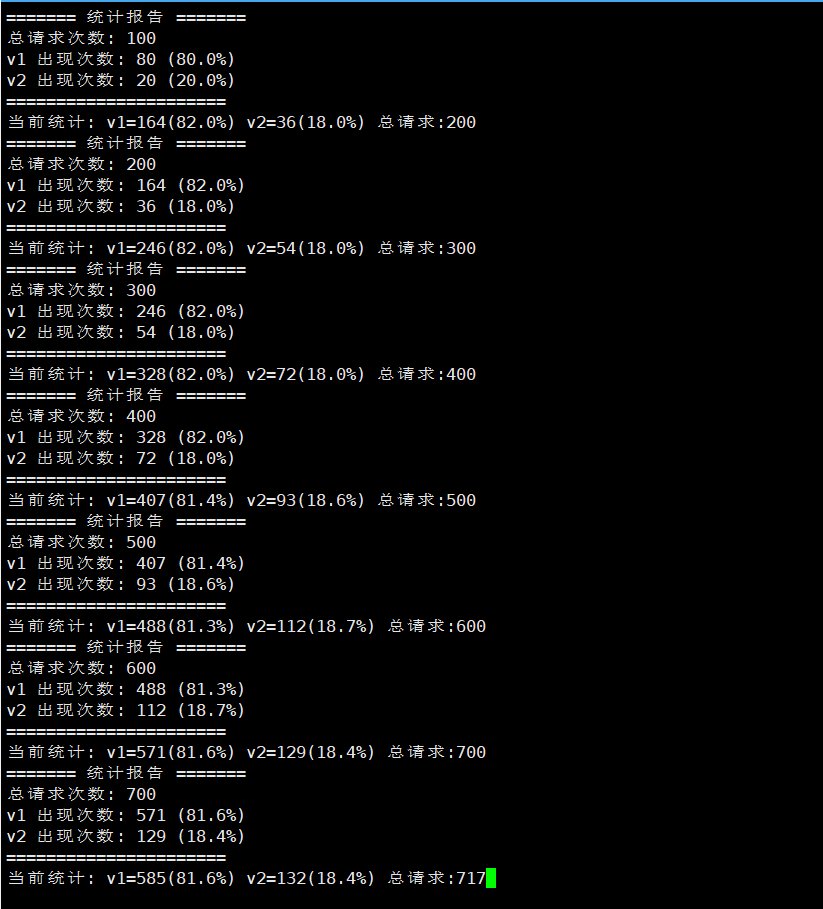

十三、流量比例监控脚本

为了实时监控v1与v2版本的流量分配比例,可以使用以下监控脚本:

1. monitor.sh 脚本内容

#!/bin/bash

# 统计变量初始化

declare -i v1_count=0

declare -i v2_count=0

declare -i total_requests=0

#url="http://192.168.3.9:32115/system/info/version"

url="http://ruoyi.howlaisi.com/prod-api/system/info/version"

# 验证jq是否安装

if ! command -v jq &> /dev/null; then

echo "错误:需要安装jq工具解析JSON"

echo "安装命令:sudo yum install jq -y"

exit 1

fi

# 统计函数

update_stats() {

local data_value=$1

((total_requests++))

case $data_value in

"v1") ((v1_count++));;

"v2") ((v2_count++));;

esac

}

# 实时统计显示

display_stats() {

echo -ne "\r当前统计: v1=${v1_count}(${v1_percent}%) v2=${v2_count}(${v2_percent}%) 总请求:${total_requests}"

}

# 定期汇总输出

periodic_report() {

echo ""

echo "======= 统计报告 ======="

echo "总请求次数: $total_requests"

echo "v1 出现次数: $v1_count (${v1_percent}%)"

echo "v2 出现次数: $v2_count (${v2_percent}%)"

echo "======================"

}

# 主监控循环

while true; do

# 执行API请求并捕获响应

#response=$(curl -s -H "Host: ruoyi-system.ruoyi-cloud-prod-project.svc.cluster.local" "$url")

response=$(curl -s "$url")

# 解析JSON响应

data_value=$(echo "$response" | jq -r '.data // "null"')

# 更新统计数据

if [[ "$data_value" == "v1" || "$data_value" == "v2" ]]; then

update_stats "$data_value"

# 计算百分比

v1_percent=$(printf "%.1f\n" $(echo "scale=2; $v1_count*100/$total_requests" | bc))

v2_percent=$(printf "%.1f\n" $(echo "scale=2; $v2_count*100/$total_requests" | bc))

# 实时显示统计

display_stats

fi

# 每100次请求输出详细报告

if (( total_requests % 100 == 0 )); then

periodic_report

fi

# 可选:请求间隔控制(0.1秒)

# sleep 0.1

done

2. 脚本使用方法

- 将脚本保存为

monitor.sh - 添加执行权限:

chmod +x monitor.sh - 运行脚本:

./monitor.sh

3. 脚本说明

- 脚本会持续向配置的URL发送请求并统计返回的版本信息

- 实时显示v1和v2版本的请求次数及占比

- 每100次请求输出一次详细统计报告

- 需要安装

jq工具来解析JSON响应 - 可以根据实际情况修改

url变量以适应不同的环境

通过这个脚本,可以直观地监控Istio流量管理策略的效果,验证版本间的流量分配是否符合预期。

十四、总结

通过将Istio服务网格接入若依项目,我们可以实现以下价值:

- 无侵入式流量治理:无需修改应用代码即可实现流量控制、超时、重试等功能

- 精细化流量管理:支持灰度发布、A/B测试等高级部署策略

- 增强系统安全性:通过mTLS和授权策略提升服务间通信安全

- 提升可观察性:通过集成监控和追踪工具获得系统全面洞察

- 提高系统稳定性:通过熔断器和故障注入等机制增强系统容错能力

当与ArgoCD Image Updater结合使用时,需要注意确保服务更新过程中的连接稳定性,通过合理的健康检查和滚动更新策略来保障服务的连续性。

即使只对单个微服务(如ruoyi-system)启用Istio,也能获得服务网格带来的好处,包括流量管理、监控和安全增强等功能。

通过实现ruoyi-system多版本共存并注册到Nacos的方案,可以实现更灵活的灰度发布策略,同时保持服务调用的一致性和透明性。

Istio与若依项目的结合,为传统微服务架构提供了现代化的服务治理能力,帮助企业更好地应对复杂业务场景下的技术挑战。

参考文档:

评论区